728x90

안녕하세요. 이번 포스팅에서는 베이지안 학습의 기초에 대해서 배워보도록 하겠습니다.

머신러닝을 깊숙히 이해하기 위해서는 베이즈 확률론이 필수라고 할 수 있습니다.

기초적인 확률론을 배워보자면 P(A)는 이벤트 A가 일어날 확률을 의미합니다.

그리고 P(A|B)는 이벤트 B가 일어났을 때, 이벤트 A가 일어날 확률을 의미합니다.

다음으로, 알아야 할 개념은 사전확률과 사후확률입니다.

사전확률이란 아무런 정보도 없을 때의 가설에 대한 확률입니다.

예를들어서, A라는 사람이 있는데, 친구 B가 "A가 감기에 걸렸을 확률은 50%일 것이야."라는 가설을 세울 수 있습니다.

이 때, 사전확률은 A가 감기에 걸렸을 확률은 = 1/2로 정의됩니다.

그런데 이 후, 새로운 정보가 들어왔습니다.

B가 오늘 아침에, A가 콧물이 계속 나고, 기침을 하고 약을 먹고 있는 것을 관측하게 되었습니다.

그러면 B는 처음 세웠던 가설에서 더 확신을 할 수 있게됩니다.

B는 이제 "A가 감기에 걸렸을 확률은 80%일 것이야."라는 가설로 다시 세울 수 있습니다.

이 때, 정의되는 것이 사후확률로 A가 감기에 걸렸을 확률은 = 4/5가 됩니다.

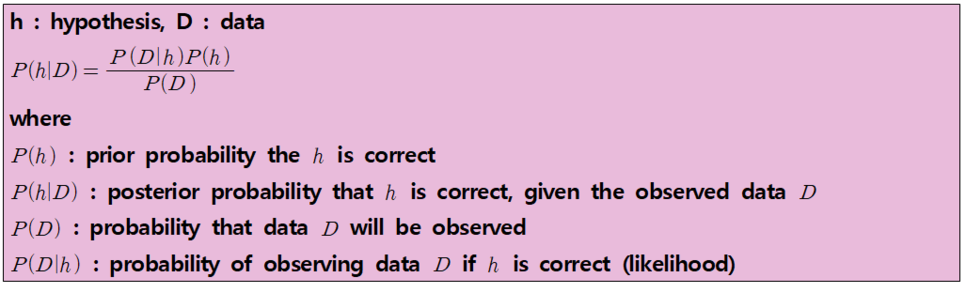

이를 수학적으로 표기해보겠습니다.

'데이터 다루기 > 머신러닝 이론' 카테고리의 다른 글

| [머신러닝] 신경망에서의 Maximum Likelihood (0) | 2019.10.20 |

|---|---|

| [머신러닝] MAP (Maximum a Posterior) (0) | 2019.10.19 |

| [머신러닝] Minimum-redundancy-maximum-relevance (mRMR) (1) | 2019.07.03 |

| [머신러닝] Feature Selection (0) | 2019.07.03 |

| [머신러닝] 랜덤 포레스트 (Random Forest) (0) | 2019.07.03 |