728x90

반응형

안녕하세요, 이번 포스팅부터는 경사하강법에 대해서 배워보도록 하겠습니다.

경사하강법은 신경망 모델에서 오차를 최소화 시키는 방법입니다.

그중에서 가장 기초가 되는 단층 신경망 (Adaline) 에서의 오차를 최소화 시키는 방법에 대해서 배워보도록 합시다.

Adaline 과 Perceptron 은 어떤 임계치에 대하여 그 값을 기준으로 선형 이진 분류를 한다는 공통점이 있습니다.

하지만 이 둘의 차이는 Perceptron은 에러를 계산할 때, 아웃풋의 클래스를 이용하지만, Adaline은 임계치 함수에 들어가기 전의 실수 값을 오차 계산에 사용합니다.

따라서 Adaline이 학습할 때에는 더 powerful 하게 분류에 대한 정보를 제공한다고 생각하시면 됩니다.

이제 Adaline의 오차를 계산해봅시다.

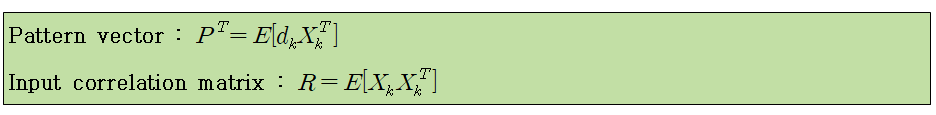

오차는 위와 같이 복잡하게 정의되기 때문에, 보기 쉽게하기 위해서 식의 부분부분을 다른 변수로 치환하도록 하겠습니다.

이제 오차를 최소화시키는 W 벡터를 찾도록 합시다. (미분을 통해 0이 되면 최소값을 가집니다.)

이처럼 오차의 최소를 가지는 w hat 을 얻을 수 있습니다.

반응형

'데이터 다루기 > 신경망' 카테고리의 다른 글

| [신경망] 6. 활성화 함수 (Activation Function) (0) | 2019.06.03 |

|---|---|

| [신경망] 5. 역전파 알고리즘 (Backpropogation) (0) | 2019.06.01 |

| [신경망] 4. 경사하강법 (Gradient Descent) (3) Momentum (0) | 2019.06.01 |

| [신경망] 3. 경사하강법 (Gradient Descent) (2) BGD, SGD (0) | 2019.06.01 |

| [신경망] 1. 퍼셉트론 (0) | 2019.06.01 |